IA y Violencia de Género: Casos de Deepfakes en América Latina y el Caribe

Diferentes casos de deepfakes sexuales en América Latina y el Caribe revelan cómo la inteligencia artificial se utiliza para agredir y exponer a mujeres sin su consentimiento. Las imágenes manipuladas circulan tanto en espacios digitales como en entornos presenciales, incluidos colegios y universidades, provocando acoso, estigmatización y daño psicológico. Lo que se presenta como innovación tecnológica opera, en realidad, como una forma de violencia digital con impactos persistentes.

Casos situados en América Latina y el Caribe

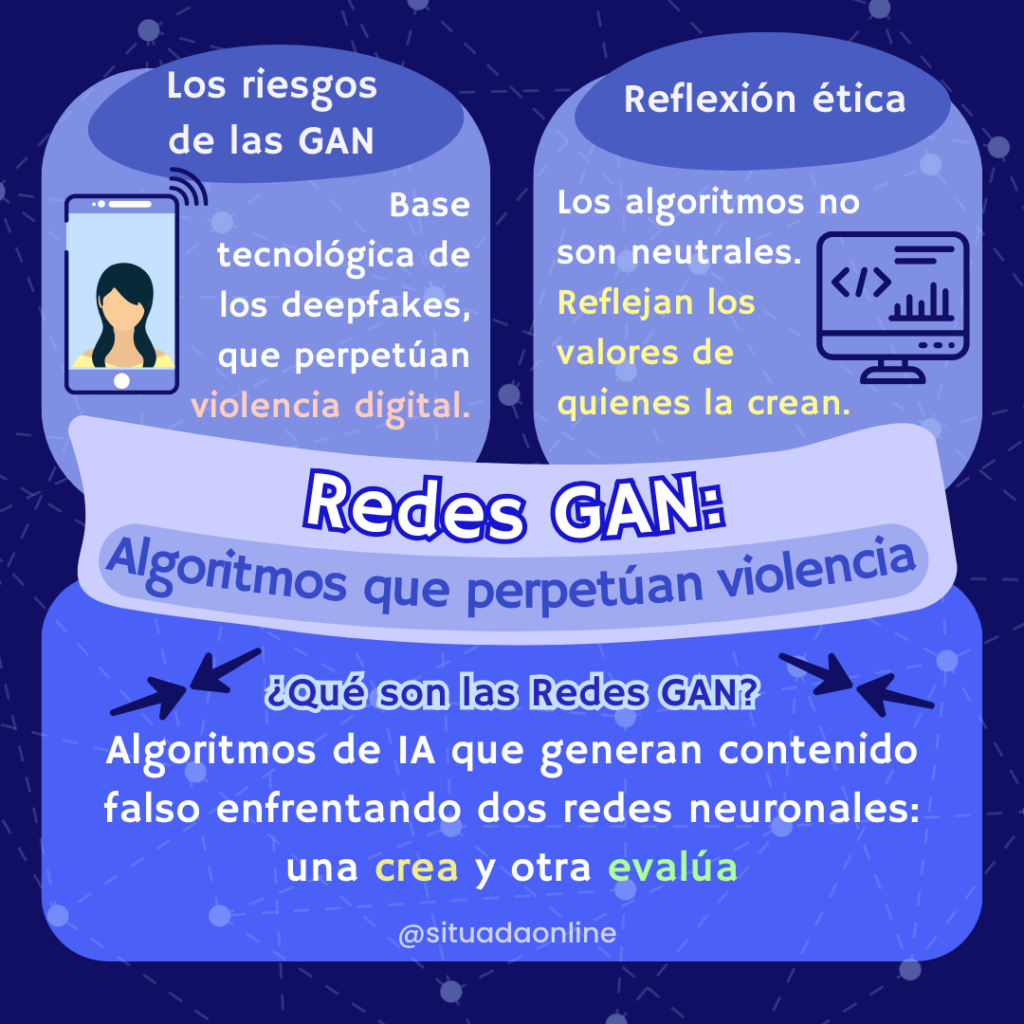

En los últimos dos años, una serie de casos ha demostrado que los deepfakes ya no son una amenaza futura: son una forma de violencia digital presente y recurrente. La mayoría de estos casos tiene como insumo imágenes de mujeres tomadas sin consentimiento para ser manipuladas con inteligencia artificial (IA) y convertidas en material sexual falso. Este fenómeno, muchas veces disfrazado de novedad tecnológica, reproduce las lógicas más clásicas de control, cosificación y exposición no consentida de los cuerpos de las mujeres.

En países como Argentina, Bolivia, Chile, Ecuador, Brasil y Perú, los casos se han dado principalmente en entornos escolares. La tecnología no llega sola, sino que se entrelaza con dinámicas ya existentes de poder y violencia de género. Las imágenes intervenidas con IA suelen originarse a partir de fotos compartidas en redes sociales, muchas veces en contextos cotidianos (como una selfie o una foto de perfil), que luego son procesadas por herramientas o apps accesibles y gratuitas. Los agresores, generalmente compañeros del mismo entorno educativo, transforman estas imágenes en material sexual explícito, que es compartido por mensajería privada o en grupos de plataformas como Telegram.

La lógica detrás de estos actos va más allá del simple “entretenimiento”. En varios casos, las imágenes fueron comercializadas, generando un pequeño mercado (por ahora) donde los cuerpos de las compañeras se convirtieron en bienes de intercambio. En Argentina, Brasil, Perú y Cuba, los deepfakes eran ofrecidos a través de redes cerradas o grupos de chat, revelando la existencia de circuitos de consumo específicos para este tipo de violencia. En Cuba, por ejemplo, un canal en Telegram amenazaba con incluir en su “base de datos” a quienes denunciaban públicamente el contenido.

En otros países, como México, Costa Rica y Honduras, las mujeres víctimas fueron figuras públicas: una streamer, una periodista, e incluso una precandidata presidencial. Estos casos muestran cómo el uso de deepfakes con fines de agresión trasciende los espacios y puede convertirse en una herramienta de desprestigio en el ámbito público. Incluso cuando se prueba que las imágenes son falsas, cumplen su propósito simbólico: humillar, desestabilizar, generar duda.

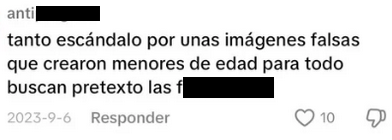

A pesar de las diferencias culturales o sociales entre países, el patrón se repite: el cuerpo de las mujeres se convierte en material manipulable, intercambiable, y públicamente expuesto a través de la tecnología. En casi todos los casos, la manipulación con IA no es percibida inicialmente como violencia, sino como una “broma”, una “travesura” o una “ficción”. Esta banalización refuerza el problema, al legitimar la idea de que si el cuerpo es falso, el daño también lo es.

Consecuencias más allá de lo digital: afectaciones reales

La violencia ejercida a través de deepfakes no termina en la creación o difusión de las imágenes. Por el contrario, lo que comienza como una manipulación aparentemente “virtual” desencadena consecuencias profundamente reales y duraderas. La idea de que lo digital no tiene impacto en la vida concreta es una forma de minimizar el daño, y prolonga el mismo discurso que históricamente ha desacreditado las experiencias de las mujeres cuando denuncian violencia.

En los casos analizados en la región, las afectadas experimentaron síntomas de ansiedad, vergüenza, miedo, trastornos del sueño y retraimiento social. Algunas dejaron de asistir a clases, otras vieron afectado su rendimiento académico o su participación en actividades cotidianas. El daño también se manifiesta en transformaciones abruptas de rutina, aislamiento voluntario y pérdida de confianza en el entorno cercano.

Una de las consecuencias más dolorosas es el estigma social, que persiste incluso cuando se comprueba que el contenido es falso. En Argentina y Ecuador, por ejemplo, algunas víctimas eran menores de edad, y aun así fueron blanco de burlas, acoso e hipersexualización. El hecho de que la imagen sea falsa no impide que cambie la percepción social. De hecho, la veracidad muchas veces resulta irrelevante ante el juicio público: lo que se ve, aunque no sea real, basta para juzgar, señalar o agredir.

En algunos contextos, el contenido manipulado queda permanentemente asociado al nombre de la víctima. Esto genera un daño reputacional con impacto directo en su vida profesional, educativa o afectiva. Incluso en los casos donde se logra eliminar parte del material, la persistencia de copias en otros espacios refuerza la sensación de que el daño nunca desaparece por completo. Como señaló un abogado en uno de los casos argentinos, la huella digital “es un castigo de por vida”.

Este escenario se agrava por el sentimiento de culpa o vergüenza que muchas víctimas llegan a experimentar, especialmente cuando las imágenes falsas se originaron a partir de fotos que ellas mismas publicaron —incluso si era solo una imagen de perfil o un retrato cotidiano. El impacto de los deepfakes no se reduce a un archivo compartido, es un proceso de daño sostenido que compromete la salud mental, la integridad y el derecho a habitar espacios (físicos y digitales) sin miedo.

Respuestas institucionales y vacíos en protección

Frente a la proliferación de deepfakes, la respuesta institucional ha sido, en la mayoría de los casos, tardía e insuficiente, dejando a las víctimas sin protección y reforzando la percepción de impunidad hacia una forma de violencia digital en expansión. Uno de los problemas más frecuentes es la inacción de las instituciones educativas. En colegios de países como Argentina, Chile, Perú o Ecuador, las autoridades no activaron protocolos de atención, minimizaron los hechos o incluso responsabilizaron a las víctimas por haber compartido sus fotos en redes sociales. En lugar de aplicar sanciones o brindar contención, se priorizó preservar la imagen institucional, aún a costa del bienestar de las afectadas.

En algunos casos, los agresores fueron enviados a clases virtuales, suspendidos temporalmente o trasladados de aula. Pero en otros, las víctimas debieron seguir compartiendo espacios con ellos. Además, las medidas adoptadas se enfocaron más en controlar a las estudiantes (con entrevistas reiteradas, monitoreo de redes sociales o llamados a la reflexión familiar) que en abordar la violencia ejercida contra ellas.

En el ámbito judicial, el panorama tampoco es alentador. En Argentina, por ejemplo, la ausencia de una figura legal específica obligó a los abogados a buscar “atajos jurídicos” para procesar la creación de pornografía falsa con IA. Aunque México cuenta con la Ley Olimpia, su aplicación suele depender de que las víctimas impulsen procesos extensos y revictimizantes. En países como Bolivia o Cuba, las investigaciones se iniciaron solo tras presión pública, no como parte de un protocolo institucional. Incluso donde existen marcos de actuación —como el Protocolo de atención frente a violencia digital en Ecuador—, su implementación ha sido limitada y tardía.

El hecho de que las imágenes sean “falsas” lleva a muchas instituciones a minimizar su impacto, sin reconocer que lo vulnerado no es solo la veracidad de una imagen, sino el derecho a la dignidad, la privacidad y la autonomía. La expansión de los deepfakes ha evidenciado una institucionalidad desbordada (sin preparación jurídica, sin formación pedagógica adecuada y sin una comprensión integral del daño). En este vacío, son las propias mujeres quienes terminan cargando con la denuncia, defensa y reparación.

Una tecnología que ignora sus consecuencias no es innovación, es negligencia

Los deepfakes de tipo sexual no se limitan a celebridades ni ocurren en la deep web: se originan en escuelas, universidades, redes sociales, y afectan a mujeres cuyas vidas se ven alteradas por completo. Esta tecnología, presentada muchas veces como un avance técnico neutral, es utilizada sistemáticamente como una herramienta de agresión y cosificación.

Pensar que esta violencia es “virtual” o “menos real” es parte del problema. Los impactos que provoca son profundas y duraderas. Lo que sucede en entornos digitales no queda encerrado en una pantalla: se encarna en los cuerpos, en la salud mental, en las trayectorias educativas, profesionales y en la vida cotidiana de quienes son expuestas sin consentimiento.

Por eso, discutir sobre deepfakes no puede reducirse a un debate técnico, ni a la fascinación por el avance de la inteligencia artificial. Lo que está en juego es la dignidad y seguridad de las personas, especialmente de aquellas históricamente más vulneradas. En la era digital, proteger los derechos humanos implica también cuestionar cómo se crean, usan y normalizan ciertas tecnologías, y a quiénes terminan dañando cuando se desarrollan perspectiva ética ni regulación.

XCC